Deepfake Tespitinde Yeni Yöntem: Işığa Gizlenen Filigranlar

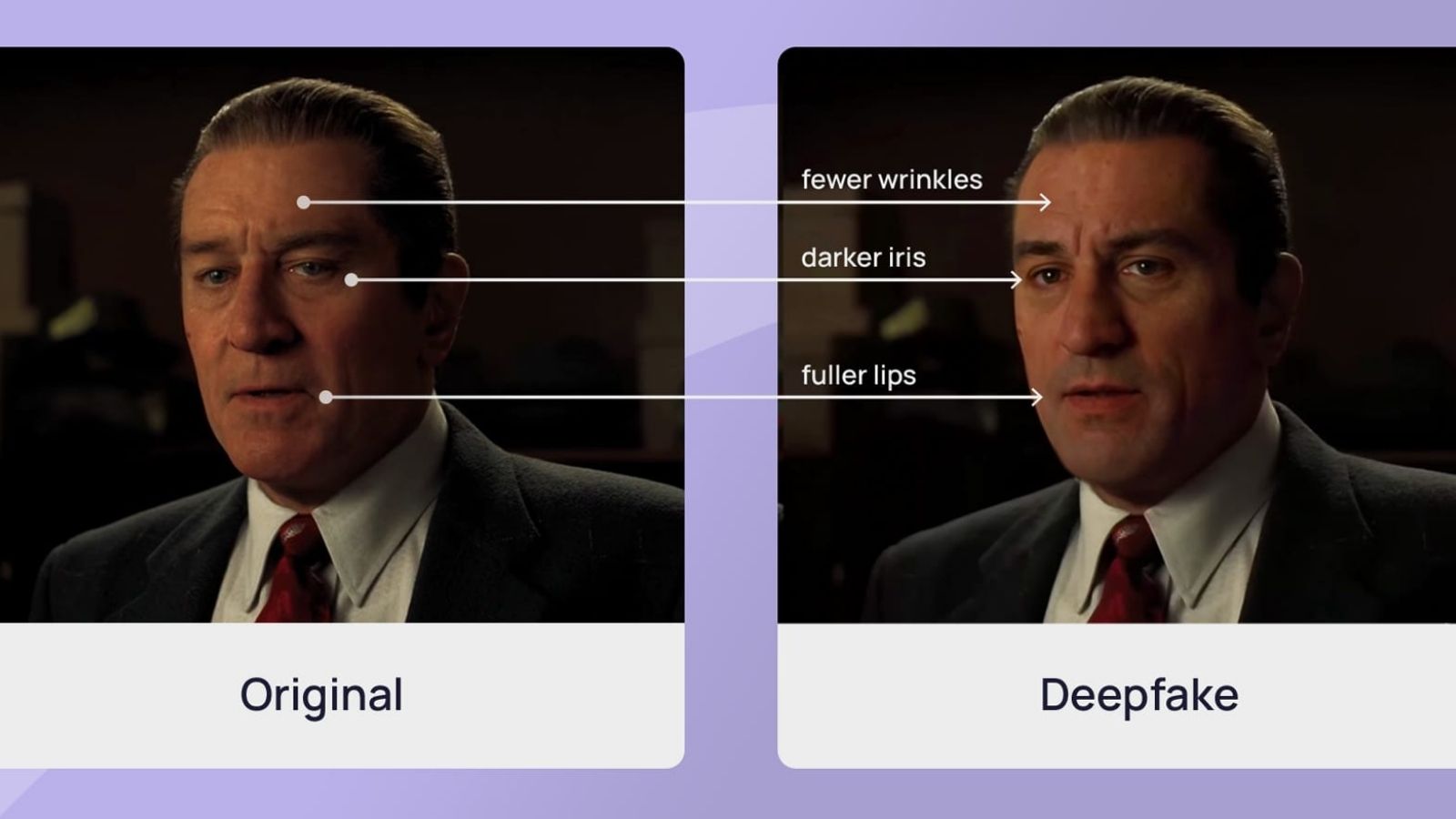

Yapay zekâ takviyeli görüntü manipülasyonlarının artması, düzmece içerikleri tespit etmeyi her zamankinden daha sıkıntı hale getiriyor. Deepfake teknolojileri, gerçeklik algısını önemli biçimde tehdit ederken, araştırmacılar bu probleme karşı daha tesirli tahliller geliştirmeye odaklanıyor. Cornell Üniversitesi’nden bir grup, bu alanda dikkat cazip bir adım atarak manipülasyon tespitini kolaylaştıracak yeni bir yol duyurdu.

Haziran ayında ACM Transactions on Graphics mecmuasında yayımlanan ve SIGGRAPH 2025’te sunulan bu yol, görüntü karelerindeki ışık kaynaklarına gizlenen özel filigranları temel alıyor. “Gürültü kodlu aydınlatma” olarak isimlendirilen bu teknik, görüntüye yapılan her türlü müdahaleyi algılayarak içerik doğrulamada kıymetli bir araç sunuyor.

Işık Dalgalanmalarına Dayalı Filigranlama

Yeni formülde, görüntüde yer alan ışık kaynaklarının dalgalanmaları içerisine özel kodlar yerleştiriliyor. Bu kodlar, görüntü değiştirilmediğinde dengeli bir halde kalırken, manipülasyon yapıldığında bozuluyor ve değişikliklerin tespit edilmesini sağlıyor. Araştırma grubuna nazaran bu teknik, hem gerçek hem de yapay zeka ile üretilmiş geçersiz görüntüleri ortaya çıkarmada tesirli bir tahlil sunuyor.

Bilgi Asimetrisi ile Güçlendirilmiş Güvenlik

Cornell grubunun yaklaşımında “bilgi asimetrisi” kavramı belirleyici bir öge olarak yer alıyor. Bu, yalnızca içerik üreticisinin erişebileceği bilgilere dayalı bir doğrulama sistemi sunuyor. Klasik dijital filigranlama tekniklerinden farklı olarak, bu yaklaşım sahtecilik yapanların kodlara erişip taklit etmesini büyük ölçüde güçleştiriyor.

Kod Görüntülerle Manipülasyon Tespiti

Filigranlar, “kod video” ismi verilen düşük çözünürlüklü ve vakit damgalı versiyonlar olarak fonksiyon görüyor. Görüntüye yapılan en ufak bir müdahale bile kodlarla uyuşmayarak manipülasyonun hangi kısımlarda yapıldığını açıkça gösteriyor. Bu sayede hem içerik doğrulayıcılar hem de izleyiciler, geçersiz imgeleri daha süratli fark edebiliyor.

Geniş Kapsamlı Testlerde Başarılı Sonuçlar

Ekip, usulü sürat değişiklikleri, montajlar, kamera hareketleri ve flaş ışığı üzere farklı manipülasyon senaryolarında test etti. Elde edilen sonuçlar, sistemin iç ve dış yer çekimlerinde yüksek muvaffakiyet sağladığını gösterdi. Ayrıyeten, farklı deri tonları ve ışık şartlarında da tesirli olmaya devam ettiği belirtildi.

Geleceğin Güvenlik Teknolojisi Olabilir

Araştırmacılar, deepfake ve öbür görüntü manipülasyon tekniklerinin gelecekte daha da ilerleyeceğini, bu yüzden tespit metotlarının daima güncellenmesi gerektiğinin altını çiziyor. Cornell Üniversitesi’nin geliştirdiği bu ışık tabanlı filigranlama sistemi, dijital içerik güvenliğinde yeni bir standart oluşturabilecek potansiyele sahip görünüyor.

Kaynak: İndir